前言

上一篇介绍了如何训练并导出图像分割模型,得到模型之后是要使用的,本文将为大家介绍如何使用 TensorFlow Serving 和 Flask 部署图像分割模型服务。

TensorFlow Serving

TensorFlow Serving 是一个灵活、高性能的机器学习模型服务系统,专为生产环境而设计。它处理机器学习的推理方面,部署训练后的模型并管理其生命周期,通过高性能、引用计数查找表为客户提供版本化访问。TensorFlow Serving 提供与 TensorFlow 模型开箱即用的集成,也可以轻松扩展以服务其他类型的模型和数据。

特性

- 可以同时为多个模型或同一模型的多个版本提供服务

- 公开 gRPC 和 HTTP 推理端点

- 允许在不更改任何客户端代码的情况下部署新模型版本

- 支持金丝雀新版本和 A/B 测试实验模型

- 由于高效、低开销的实现,为推理时间增加了最小的延迟

- 具有调度程序,可将单个推理请求分组,以便在 GPU 上联合执行,并具有可配置的延迟控制

- 支持多种 servables:Tensorflow 模型,embeddings,vocabularies,功能的转换和非基于 Tensorflow 的机器学习模型

使用

推荐大家用 Docker 的方式来使用 TensorFlow Serving。

快速开始

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

# 拉取 docker 镜像

$ docker pull tensorflow/serving

# 下载测试模型数据

$ git clone --depth=1 https://github.com/tensorflow/serving

$ TESTDATA="$(pwd)/serving/tensorflow_serving/servables/tensorflow/testdata"

# 运行模型服务,并开启 REST API 端口(8501)

$ docker run --name=serving-test -d -p 8501:8501 \

-v "$TESTDATA/saved_model_half_plus_two_cpu:/models/half_plus_two" \

-e MODEL_NAME=half_plus_two \

tensorflow/serving

# 请求模型 predict API

$ curl -d '{"instances": [1.0, 2.0, 5.0]}' \

-X POST http://localhost:8501/v1/models/half_plus_two:predict

# 返回 => { "predictions": [2.5, 3.0, 4.5] }

# 清理

$ docker rm -f serving-test

注:

gRPC公开的端口8500REST API公开的端口8501- 可选的环境变量

MODEL_NAME(默认为model)- 可选的环境变量

MODEL_BASE_PATH(默认为/models)

创建镜像

基于 tensorflow/serving 创建自己的模型镜像

1

2

3

4

5

6

$ docker run -d --name serving_base tensorflow/serving

# 将模型拷贝到 serving_base 容器中

$ docker cp $TESTDATA/saved_model_half_plus_two_cpu serving_base:/models/half_plus_two

# 设置模型名称环境变量,并将修改 serving_base 后的容器提交为 half_plus_two

$ docker commit --change "ENV MODEL_NAME half_plus_two" serving_base half_plus_two

$ docker rm -f serving_base

运行镜像

1

2

3

4

5

6

7

8

9

$ docker run --name=half_plus_two -d -p 8501:8501 half_plus_two

# 请求模型 predict API

$ curl -d '{"instances": [1.0, 2.0, 5.0]}' \

-X POST http://localhost:8501/v1/models/half_plus_two:predict

# 返回 => { "predictions": [2.5, 3.0, 4.5] }

# 清理

$ docker rm -f half_plus_two

图像分割 Serving Docker 镜像

介绍完 TensorFlow Serving 的基本用法,下面为大家介绍如何构建 Serving Docker 镜像。

创建镜像

模型导出后,可以得到如下模型

1

2

3

4

5

6

7

8

9

10

11

12

test-mask

├── exported-models

│ └── mask_rcnn_inception_resnet_v2_1024x1024_coco17_gpu-8

│ ├── checkpoint

│ │ ├── checkpoint

│ │ ├── ckpt-0.data-00000-of-00001

│ │ └── ckpt-0.index

│ ├── pipeline.config

│ └── saved_model

│ ├── assets

│ ├── saved_model.pb

│ └── variables

如果大家训练模型不方便,可以前往 https://github.com/CatchZeng/object-detection-api/releases/tag/exported-models 下载

test-mask的模型,进行后面的步骤。

执行以下命令,制作 Serving Docker 镜像。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

$ make serving

docker pull tensorflow/serving

Using default tag: latest

latest: Pulling from tensorflow/serving

Digest: sha256:6651f4839e1124dbde75ee531825112af0a6b8ef082c88ab14ca53eb69a2e4bb

Status: Image is up to date for tensorflow/serving:latest

docker.io/tensorflow/serving:latest

docker run -d --name serving_base tensorflow/serving

7239e7a1b83ba7b5c4244973f2b327ba703d19fcdfc451e52221179772a9e61b

# https://stackoverflow.com/a/45552938/14785930

docker exec -it serving_base mkdir -p /models/test-mask/1

docker cp exported-models/mask_rcnn_inception_resnet_v2_1024x1024_coco17_gpu-8/saved_model/. serving_base:/models/test-mask/1

docker commit --change "ENV MODEL_NAME test-mask" serving_base test-mask

sha256:20a3d099a6ce03dad70003752c70b68aeda706c1e6d5434e6b9d945098ab692c

docker rm -f serving_base

serving_base

$ docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

test-mask latest 20a3d099a6ce 10 seconds ago 663MB

本地调试

启动 Serving

1

$ docker run -d --name test-mask --rm -p 8500:8500 -p 8501:8501 test-mask

拷贝一张测试图片到 images/test 下并命名为 test.jpg,然后执行以下命令测试 Serving。

1

2

3

4

5

6

$ make serving-test

python deployments/serving/client.py

start request

duration: 17.50s

......

annotated image is saved to /Users/catchzeng/Documents/Code/CatchZeng/object-detection-api/workspace/test-mask/images/test/test_annotated.jpg

Flask

有了模型镜像后,还需要一个入口服务来做对外 API 设计和输入数据预处理,这里通常使用 Flask。

Flask 是一个轻量级的可定制 Web 应用框架,使用 Python 语言编写,较其他同类型框架更为灵活、轻便、安全且容易上手。

安装

1

2

$ conda activate od

$ pip install Flask

使用

创建 app.py

1

2

3

4

5

6

7

8

9

# app.py

from flask import Flask

app = Flask(__name__)

@app.route("/")

def hello_world():

return "It works!"

运行

1

2

3

4

5

6

$ python -m flask run

* Environment: production

WARNING: This is a development server. Do not use it in a production deployment.

Use a production WSGI server instead.

* Debug mode: off

* Running on http://127.0.0.1:5000/ (Press CTRL+C to quit)

请求

1

2

❯ curl http://127.0.0.1:5000

It works!

更多的入门实例,请参见 https://flask.palletsprojects.com/en/2.0.x/quickstart/。

图像分割入口服务

创建镜像

执行以下命令,构建 Flask 图像分割入口服务镜像。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

$ make flask

cp annotations/label_map.pbtxt deployments/flask

cd deployments/flask && make build

DOCKER_BUILDKIT=0 docker build --tag test-mask-flask .

Sending build context to Docker daemon 66.05kB

Step 1/6 : FROM python:3.8-slim-buster

---> 09c82f264230

Step 2/6 : WORKDIR /app

---> Using cache

---> 38fe51c7abd9

Step 3/6 : RUN pip3 install --no-cache-dir Flask pillow tensorflow==2.6.0

---> Using cache

---> 7d5da785bd60

Step 4/6 : COPY . .

---> Using cache

---> f65126d49639

Step 5/6 : RUN rm -rf .vscode README.md Dockerfile Makefile

---> Using cache

---> eb6dc93afc91

Step 6/6 : CMD [ "python3", "-m" , "flask", "run", "--host=0.0.0.0"]

---> Using cache

---> 3991ff08b36f

Successfully built 3991ff08b36f

Successfully tagged test-mask-flask:latest

Use 'docker scan' to run Snyk tests against images to find vulnerabilities and learn how to fix them

!!!

workspace/test-mask/deployments/flask/object_detection是从 TensorFlow Object Detection API 中摘取的部分代码,好处是制作 Docker 镜像的时候,可以不用安装 TensorFlow Object Detection API,这样可以减少生成的镜像大小(2G 左右)。

运行

启动服务

1

2

3

4

5

6

$ docker run -d --name test-mask-flask --rm -p 5000:5000 --link test-mask:test-mask -e SERVER_URL="http://test-mask:8501/v1/models/test-mask:predict" test-mask-flask

$ docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

1c78f0e1f31e test-mask-flask "python3 -m flask ru…" 2 seconds ago Up 2 seconds 0.0.0.0:5000->5000/tcp test-mask-flask

c48d559ab6c5 test-mask "/usr/bin/tf_serving…" 3 minutes ago Up 3 minutes 0.0.0.0:8500-8501->8500-8501/tcp test-mask

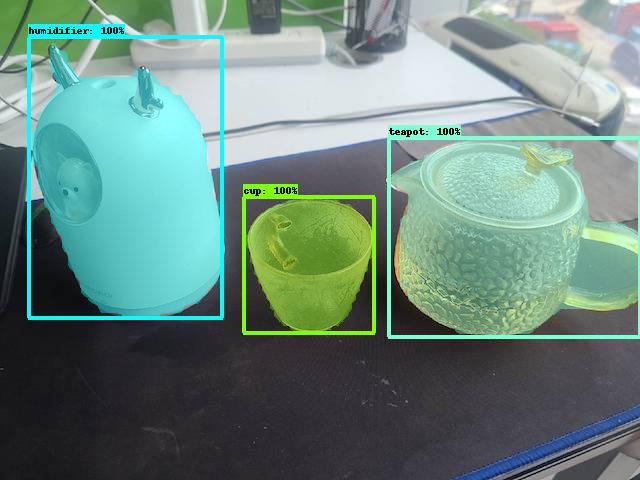

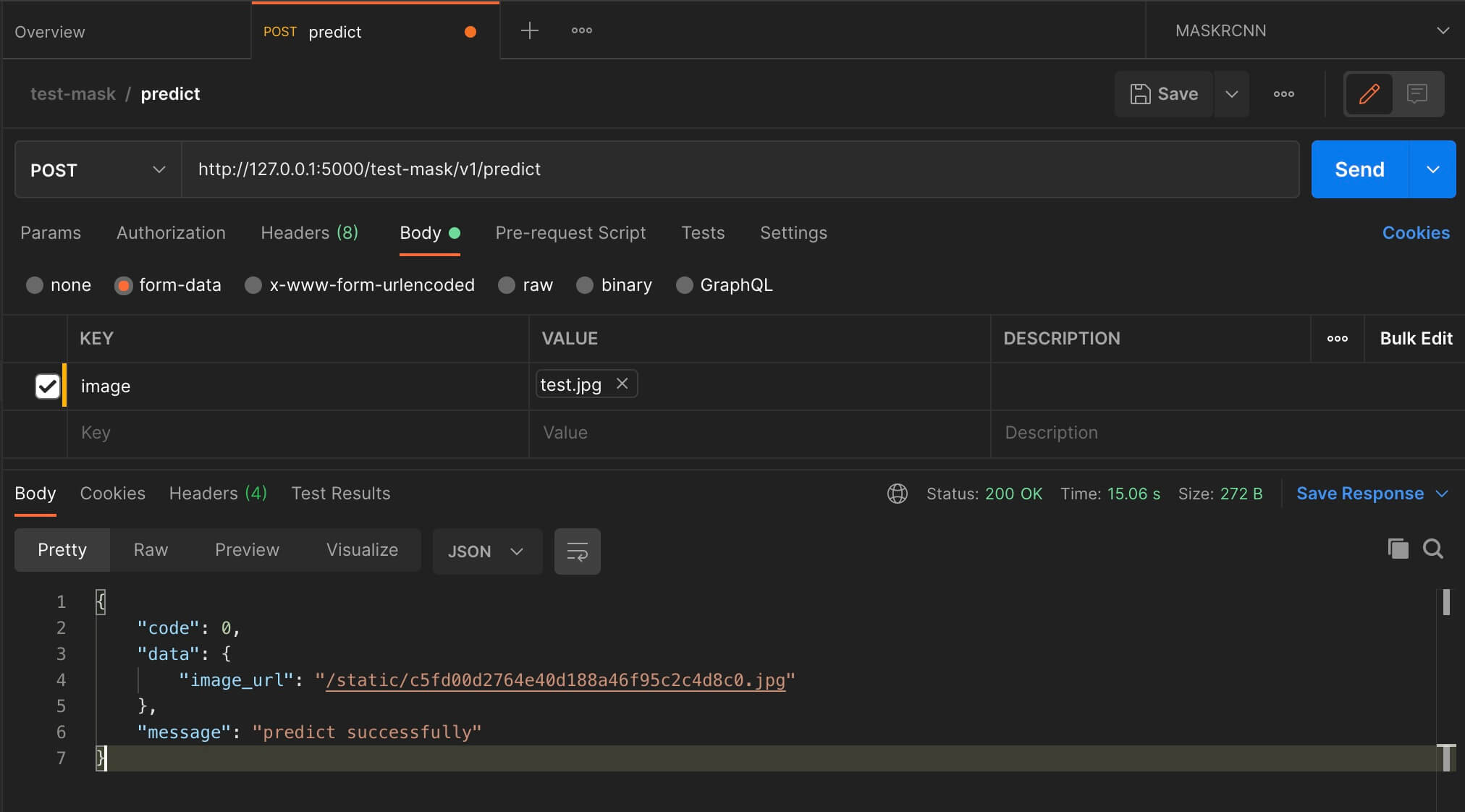

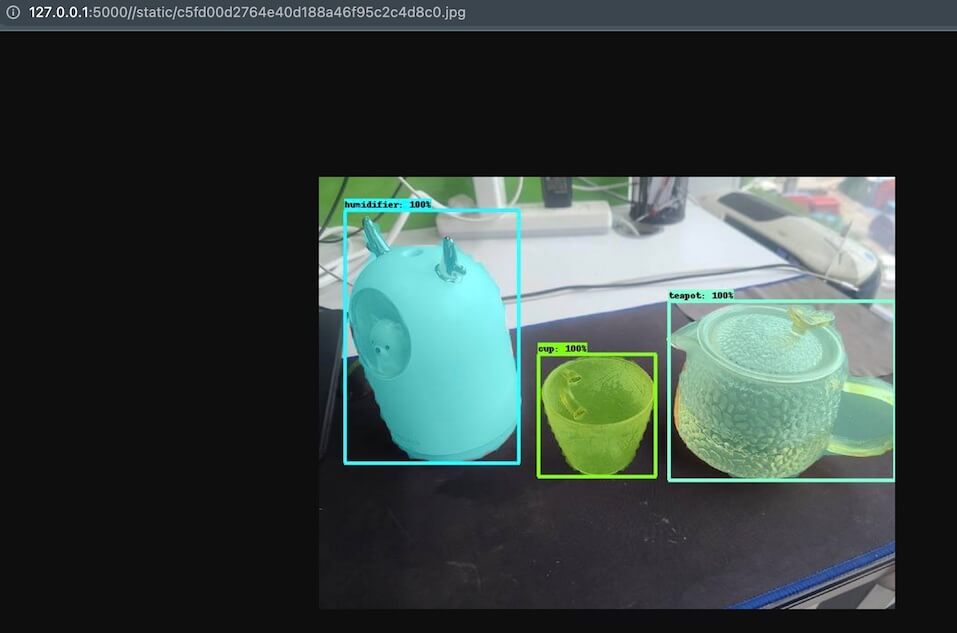

请求

部署

如果使用 Nginx 部署的话,可以参考 https://github.com/CatchZeng/object-detection-api/blob/master/scripts/workspace/mask/files/deployments/flask/nginx.conf。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

server {

listen 80;

listen 443 ssl;

server_name api.makeoptim.com;

ssl_certificate /etc/nginx/keys/api.makeoptim.com.pem;

ssl_certificate_key /etc/nginx/keys/api.makeoptim.com.key;

location / {

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_pass http://127.0.0.1:5000/;

}

}

小结

本文介绍了如何使用 TensorFlow Serving 和 Flask 部署图像分割模型服务,到了这一步,模型才算真正的交付,希望能帮助大家将训练的模型运用到实际项目中。本篇就到这了,咱们下一篇见。

延伸阅读

- 使用 TensorFlow Object Detection API 训练自定义目标检测模型

- 使用 TensorFlow Object Detection API Mask R-CNN 训练自定义图像分割模型

- 使用 TensorFlow Serving & Flask 部署图像分割(Mask R-CNN)模型服务

- 使用 TensorFlow 和 Labelme 训练自定义 U-NET 图像分割模型

The easiest way to Train a Custom Image Segmentation Model Using TensorFlow Object Detection API Mask R-CNN

The easiest way to Train a Custom Image Segmentation Model Using TensorFlow Object Detection API Mask R-CNN